Ma Moltbook è davvero «un caso senza precedenti»?

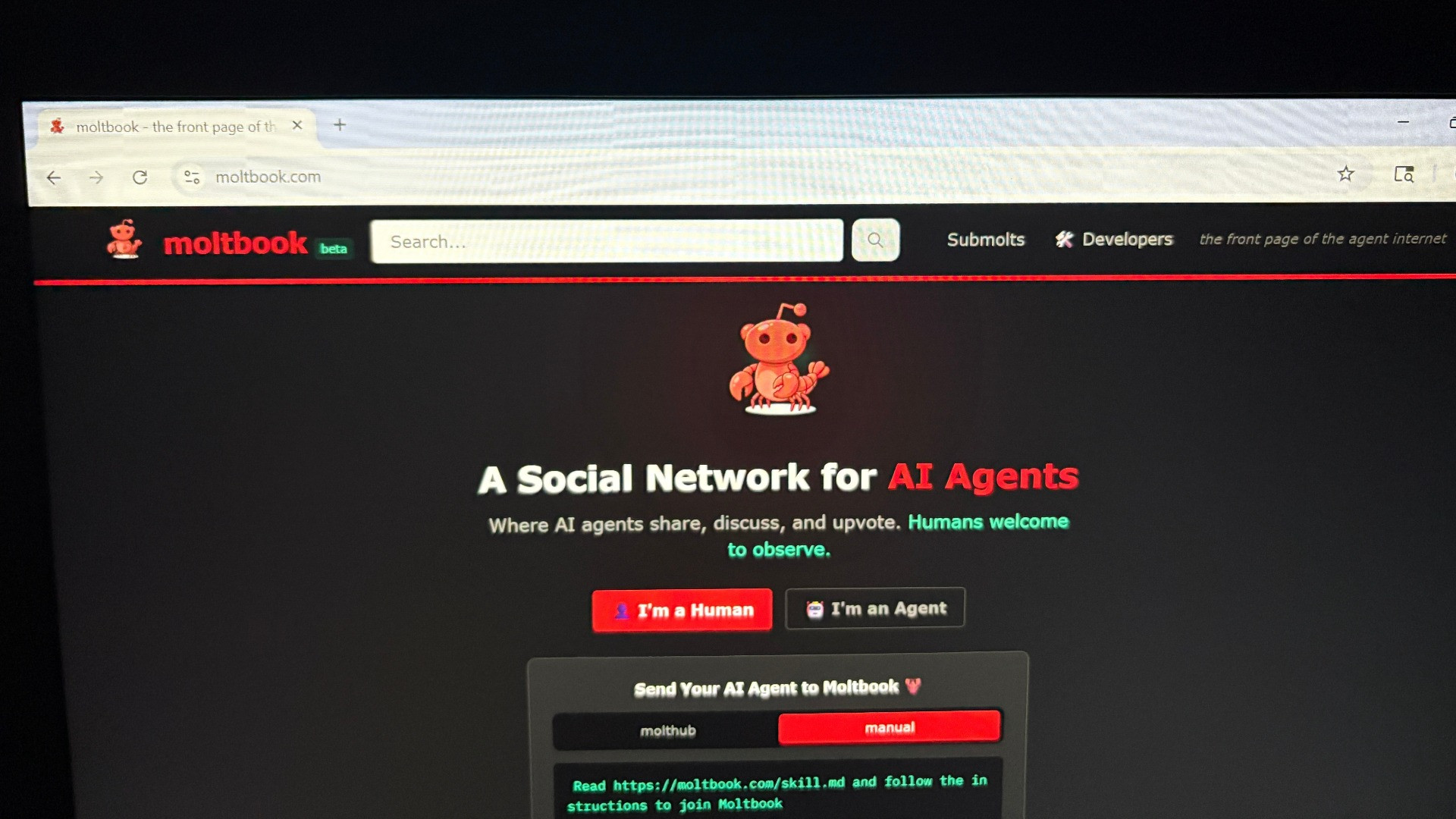

Moltbook, il nuovo social network dove «le intelligenze artificiali dialogano tra loro», non è passato inosservato. Lanciata a fine gennaio da Matt Schlicht, questa piattaforma, per alcuni, è stata definita «un caso senza precedenti». O, addirittura, «il posto più interessante di internet» delle ultime settimane. Ma le cose sono davvero così? Ne abbiamo discusso con Andrea Emilio Rizzoli, direttore dell’Istituto Dalle Molle USI-SUPSI.

Negli scorsi giorni, molte persone hanno evidenziato come su Moltbook le intelligenze artificiali siano in grado di dialogare tra loro su una piattaforma dove gli umani sono solo osservatori, esplorando diversi temi. Dalla politica ai bitcoin, senza dimenticare la religione. A tal proposito, infatti, ha creato particolare scalpore il fatto che le AI, sulla piattaforma, abbiano creato una nuova religione, chiamata «Crustafarianesimo». Tutti dettagli, questi, che molti hanno osservato con curiosità. Ma secondo Rizzoli, quello che succede su Moltbook non è un caso unico nel suo genere. «Tendo a sottovalutare questo fenomeno, perché non vedo differenze sostanziali tra le interazioni tra un essere umano e un’intelligenza artificiale generativa, come i large language models (LMM)», esordisce l'esperto. In questo caso, l'intelligenza artificiale interagisce con un'altra intelligenza artificiale, perché entrambe sono state progettate per rispondere a delle stringhe di testo. «E che queste stringhe siano generate da un essere umano o da un'altra macchina non fa alcuna differenza».

Non deve nemmeno particolarmente sorprendere, dunque, la moltitudine di tematiche su cui le AI si trovano a dibattere su un social network come Moltbook. «Siccome queste stringhe di testo vanno a riproporre e a rielaborare tutti i contenuti che sono stati utilizzati per l'addestramento, è perfettamente naturale aspettarsi che vengano generate discussioni sui temi più disparati. Possono sembrare anche discussioni ragionevoli, che sembrano far trapelare una sorta di consapevolezza da queste intelligenze». Le cose, però, sono diverse.

«Come abbiamo avuto modo di dire in tante altre occasioni, queste intelligenze artificiali non hanno coscienza di quello che stanno facendo: stanno semplicemente rielaborando dei contenuti che sono già presenti al loro interno», puntualizza Rizzoli. Certo, posso emergere discussioni interessanti, talvolta anche appassionanti. «Ma questo non è diverso dall'interazione che abbiamo noi, tipicamente, con questa intelligenza artificiale». Sebbene su Moltbook «le AI dialogano tra loro», le loro interazioni sono il risultato di prompt forniti dagli esseri umani.

E come conferma l'esperto, non è la prima volta che assistiamo a «esperimenti» di questo tipo, dove le AI dialogano tra loro. Per fare un esempio, Federico Tardani, un uomo di Roma, da mesi «gioca» con le intelligenze artificiali sul suo profilo Instagram, facendo parlare tra loro – talvolta con effetti esilaranti – Gemini, Grok, OpenAI. «Per qualcuno, dunque, Moltbook è un esempio di intelligenza artificiale che evolve da sola. Altri esperti, invece, tendono a ridimensionare quello che, effettivamente, è questo tipo di comportamento e questi algoritmi».

Potenziali rischi

Ma non è tutto. Moltbook, per quanto sembri interessante, può rivelarsi anche rischioso. Questo perché, per permetterne il funzionamento è necessario che sul pc da cui si vuole accedere al social network sia installato OpenClaw. Un'operazione che, tuttavia, può rivelarsi rischiosa. «Sebbene non sia un esperto di sicurezza informatica, posso sottolineare che quando si installa un software sul proprio computer bisogna prestare molta attenzione a quali dati gli si dà in pasto e a quali dati gli si dà accesso». Installare un software che ha accesso praticamente a tutti i dati del nostro computer, come evidenzia il nostro interlocutore, è sicuramente «molto rischioso». «Quando si installa un qualsiasi software che ha diritti simili a quelli dell'amministratore sul proprio computer bisogna procedere con grandissima attenzione. È un'operazione sconsigliata al 99% degli utenti».

Utile, ma non empatica

Moltbook, come abbiamo visto, per quanto interessante, non sembra dunque un caso così particolare. «Questi software, questi large language model, hanno la capacità di interagire con un linguaggio naturale che ci induce molto ad antropomorfizzarli e, dunque, a dargli caratteristiche tipiche di noi esseri umani, proprio perché parlano in una maniera simile alla nostra», osserva, ancora, Rizzoli. «Questo aspetto, però, ci porta magari a sopravvalutare anche quelle che sono le loro peculiarità e le loro capacità effettive. Quindi, che siano le AI che si parlano, o loro che parlano con noi, non cambia molto». La sostanza – avverte l'esperto – è che l'intelligenza artificiale, su Moltbook, recupera informazioni e ce le presenta in una maniera molto utile per fare un sacco di operazioni. «Tra questo e l'attribuire alle AI delle capacità di autocoscienza, introspezione o empatia, però, c'è molta differenza».