Il professore che bestemmia in aula? È uno dei tanti falsi generati con Sora 2

Il 30 settembre 2025 l’azienda di intelligenza artificiale OpenAI ha lanciato Sora 2, un nuovo modello IA che permette di generare video estremamente realistici, come mostrato nel video di lancio dell’azienda.

Dal suo lancio, il modello è stato utilizzato dagli utenti per creare ogni sorta di contenuto. Un’analisi di Newsguard ha evidenziato come Sora 2 abbia prodotto «video realistici che diffondevano affermazioni dimostrabilmente false nell’80% dei casi (16 su 20) in cui gli è stato chiesto di farlo». E se i video generati presentano una filigrana con il logo di Sora, è vero che questa può essere facilmente rimossa, rendendo sempre più difficile la distinzione tra video reali e video artificiali.

Così in Rete si possono trovare contenuti creati ad arte ma estremamente realistici: dall’AI slop ー contenuti privi di senso volti ad attirare click e generare traffico online ー, ai deepfake di personaggi famosi, fino ad arrivare a immagini sessiste, abiliste, grassofobiche, razziste ed estremiste.

L’AI slop strappalacrime

A metà ottobre è circolato un video che mostrava un passante afferrare al volo un neonato caduto da una finestra, presentato come una ripresa di una videocamera di sicurezza.

Tuttavia, analisi successive hanno rivelato che il filmato era stato generato con l’intelligenza artificiale. Diversi dettagli hanno tradito la sua natura artificiale: il suono innaturale dell’impatto tra l’uomo e il bambino, la caduta poco realistica del bicchiere che l’uomo teneva in mano e le scritte incomprensibili che comparivano in alto nel video. Ulteriori indizi di manipolazione sono emersi osservando alcune sfocature ai margini dell’inquadratura, riconducibili al tentativo di rimuovere il watermark mobile di Sora.

Le interviste false

Nello stesso periodo si sono diffusi vari video di persone per strada intervistate da giornalisti. In uno di questi casi, un giovane avvolto da una bandiera palestinese dice al giornalista che non è contento dell’accordo di pace raggiunto a Gaza perché ora dovrà tornare a lavorare, in quanto non ci sarebbero più motivi per manifestare. In un altro caso, un giovane migrante dice al giornalista di aver scelto l’Italia perché «qui non lavoro e prendo soldi».

A una prima occhiata veloce, entrambi i video possono sembrare reali per come sono inscenati. Tuttavia, si tratta di contenuti generati dall’intelligenza artificiale, come dimostrato da diversi dettagli. Nel primo caso, il modo in cui la bandiera palestinese è avvolta intorno al giovane è innaturale, e il bastone che la regge sembra poggiare in maniera irrealistica sulla pancia dell’intervistato. Nel secondo caso, invece, le persone sullo sfondo sono estremamente irrealistiche. Nel momento in cui si ingrandisce l’immagine, infatti, ci sono inconsistenze nel loro modo di muoversi. Inoltre, la marca sul cappello dell’intervistato non è leggibile pur essendo in primo piano.

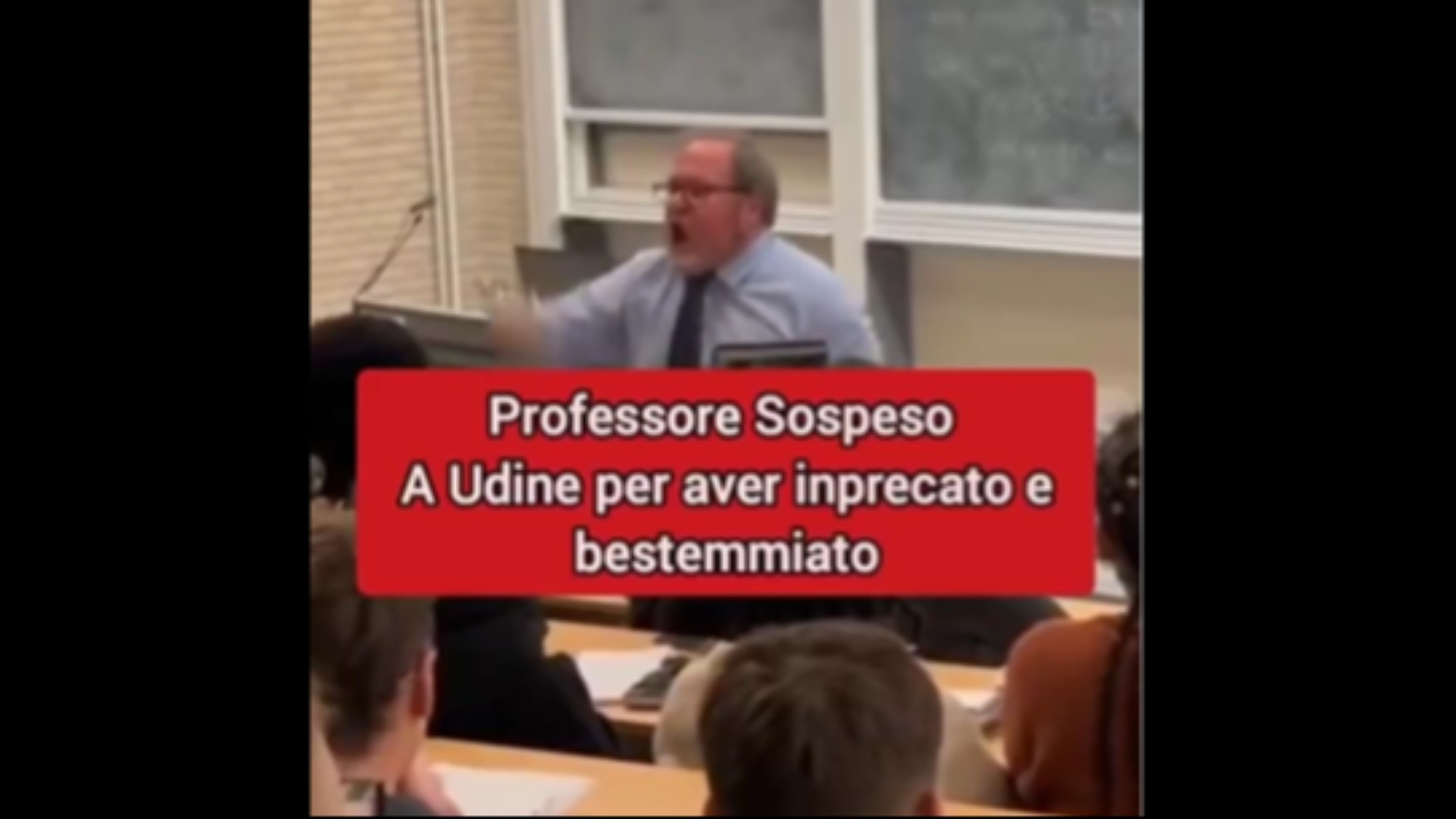

Il professore che bestemmia in aula

Tra gli altri, sui social è stato diffuso anche il video di un presunto professore dell’Università di Udine che bestemmia in aula mentre rimproverava gli studenti per l’uso improprio dell’intelligenza artificiale. Secondo la descrizione che accompagna il filmato, il professore sarebbe poi stato sospeso per aver imprecato e bestemmiato.

Il video, anche in questo caso, è completamente falso e realizzato con strumenti di intelligenza artificiale. Nessuna testata giornalistica affidabile né l’ateneo friulano hanno confermato l’episodio, e quotidiani locali come Udine Today e Messaggero Veneto hanno smentito la notizia, spiegando che la scena non è mai avvenuta. Tra gli elementi che ne rivelano la natura artificiale figurano ad esempio i movimenti innaturali e accelerati del presunto docente.